|

| 1 | +**前言** |

| 2 | + |

| 3 | +上篇文章讲解了 Kafka 的基础概念和架构,了解了基本概念之后,必须得实践一波了,所谓“实践才是检验真理的唯一办法”,后续系列关于 Kafka 的文章都以 kafka_2.11-0.9.0.0 为例;另外为了让大家快速入门,本文只提供单机版的安装实战教程,如果有想尝试集群方案的,后面在出一篇集群安装的教程,废话不多说了,直接开干。 |

| 4 | + |

| 5 | +## **安装** |

| 6 | + |

| 7 | +### **1\. 下载** |

| 8 | + |

| 9 | +版本号:kafka_2.11-0.9.0.0 |

| 10 | + |

| 11 | +下载地址:[http://kafka.apache.org/downloads](https://link.zhihu.com/?target=http%3A//kafka.apache.org/downloads) |

| 12 | + |

| 13 | +### **2\. 安装** |

| 14 | + |

| 15 | + |

| 16 | + |

| 17 | +``` |

| 18 | +# 安装目录 |

| 19 | +$ pwd |

| 20 | +/Users/my/software/study |

| 21 | +

|

| 22 | +# 减压 |

| 23 | +$ sudo tar -zxvf kafka_2.11-0.9.0.0.tgz |

| 24 | +

|

| 25 | +# 重命名 |

| 26 | +$ sudo mv kafka_2.11-0.9.0.0.tgz kafka-0.9 |

| 27 | +

|

| 28 | +# 查看目录结构 |

| 29 | +$ cd kafka-0.9 && ls |

| 30 | +LICENSE NOTICE bin config libs site-docs |

| 31 | +

|

| 32 | +# 目录结构介绍: |

| 33 | +# bin: 存放kafka 客户端和服务端的执行脚本 |

| 34 | +# config: 存放kafka的一些配置文件 |

| 35 | +# libs: 存放kafka运行的的jar包 |

| 36 | +# site-docs: 存放kafka的配置文档说明 |

| 37 | +

|

| 38 | +# 配置环境变量,方便在任意目录下运行kafka命令 |

| 39 | +# 博主使用的Mac,所以配置在了 ~/.bash_profile文件中, |

| 40 | +# Linux中则配置在 ~/.bashrc 或者 ~/.zshrc文件中 |

| 41 | +$ vim ~/.bash_profile |

| 42 | +

|

| 43 | +export KAFKA_HOME=/Users/haikuan1/software/study/kafka-0.9 |

| 44 | +export PATH=$PATH:$JAVA_HOME:$KAFKA_HOME/bin |

| 45 | +

|

| 46 | +# 使得环境变量生效 |

| 47 | +$ source ~/.bash_profile |

| 48 | +

|

| 49 | +``` |

| 50 | + |

| 51 | + |

| 52 | + |

| 53 | +### **3.运行** |

| 54 | + |

| 55 | +### **3.1 启动 zookeeper** |

| 56 | + |

| 57 | + |

| 58 | + |

| 59 | +``` |

| 60 | +# 启动zookeeper,因为kafka的元数据需要保存到zookeeper中 |

| 61 | +$ bin/zookeeper-server-start.sh config/zookeeper.properties |

| 62 | +

|

| 63 | +# 若出现如下信息,则证明zookeeper启动成功了 |

| 64 | +[2020-04-25 16:23:44,493] INFO Server environment:user.dir=/Users/haikuan1/software/study/kafka-0.10 (org.apache.zookeeper.server.ZooKeeperServer) |

| 65 | +[2020-04-25 16:23:44,505] INFO tickTime set to 3000 (org.apache.zookeeper.server.ZooKeeperServer) |

| 66 | +[2020-04-25 16:23:44,505] INFO minSessionTimeout set to -1 (org.apache.zookeeper.server.ZooKeeperServer) |

| 67 | +[2020-04-25 16:23:44,505] INFO maxSessionTimeout set to -1 (org.apache.zookeeper.server.ZooKeeperServer) |

| 68 | +[2020-04-25 16:23:44,548] INFO binding to port 0.0.0.0/0.0.0.0:2181 (org.apache.zookeeper.server.NIOServerCnxnFactory) |

| 69 | +

|

| 70 | +``` |

| 71 | + |

| 72 | + |

| 73 | + |

| 74 | +### **3.2 启动 Kafka server** |

| 75 | + |

| 76 | + |

| 77 | + |

| 78 | +``` |

| 79 | +# 以守护进程的方式启动kafka服务端,去掉 -daemon 参数则关闭当前窗口服务端自动退出 |

| 80 | +$ bin/kafka-server-start.sh -daemon config/server.properties |

| 81 | +

|

| 82 | +``` |

| 83 | + |

| 84 | + |

| 85 | + |

| 86 | +### **3.3 kafka 基础命令使用** |

| 87 | + |

| 88 | + |

| 89 | + |

| 90 | +``` |

| 91 | +# 1\. 创建一个topic |

| 92 | +# --replication-factor:指定副本个数 |

| 93 | +# --partition:指定partition个数 |

| 94 | +# --topic:指定topic的名字 |

| 95 | +$ bin/kafka-topics.sh --create --zookeeper localhost:2181 --replication-factor 1 --partition 1 --topic mytopic |

| 96 | +

|

| 97 | +# 2\. 查看创建成功的topic |

| 98 | +$ kafka-topics.sh --list --zookeeper localhost:2181 |

| 99 | +

|

| 100 | +# 3\. 创建生产者和消费者 |

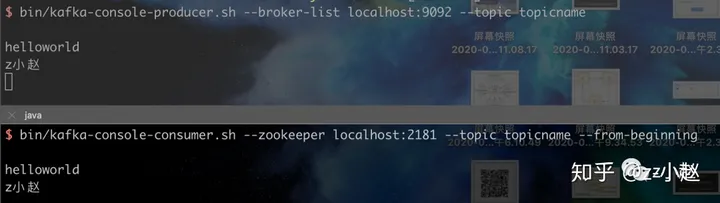

| 101 | +

|

| 102 | +# 3.1 启动kafka消费端 |

| 103 | +# --from-beginning:从头开始消费,该特性也表明kafka消息具有持久性 |

| 104 | +$ bin/kafka-console-consumer.sh --zookeeper localhost:2181 --topic mytopic --from-beginning |

| 105 | +

|

| 106 | +# 3.2 启动kafka生产端 |

| 107 | +# --broker-list:当前的Broker列表,即提供服务的列表 |

| 108 | +$ bin/kafka-console-producer.sh --broker-list localhost:9092 --topic mytopic |

| 109 | +

|

| 110 | +``` |

| 111 | + |

| 112 | + |

| 113 | + |

| 114 | +<figure data-size="normal"> |

| 115 | + |

| 116 | + |

| 117 | + |

| 118 | + |

| 119 | +</figure> |

| 120 | + |

| 121 | +### **4.使用 Java 连接 kafka 进行测试** |

| 122 | + |

| 123 | +### **4.1 创建一个 maven 工程,引入如下 pom 依赖** |

| 124 | + |

| 125 | + |

| 126 | + |

| 127 | +``` |

| 128 | +<dependency> |

| 129 | + <groupId>org.apache.kafka</groupId> |

| 130 | + kafka-clients |

| 131 | + <version>0.9.0.0</version> |

| 132 | +</dependency> |

| 133 | +

|

| 134 | +<dependency> |

| 135 | + <groupId>org.apache.kafka</groupId> |

| 136 | + kafka_2.11 |

| 137 | + <version>0.9.0.0</version> |

| 138 | +</dependency> |

| 139 | +

|

| 140 | +``` |

| 141 | + |

| 142 | + |

| 143 | + |

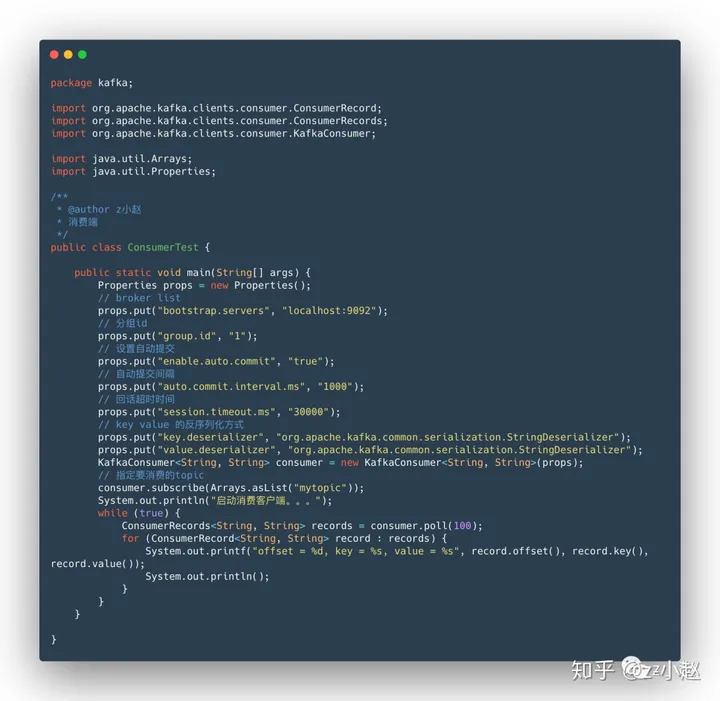

| 144 | +### **4.2 消费者端代码** |

| 145 | + |

| 146 | +<figure data-size="normal"> |

| 147 | + |

| 148 | + |

| 149 | + |

| 150 | + |

| 151 | +</figure> |

| 152 | + |

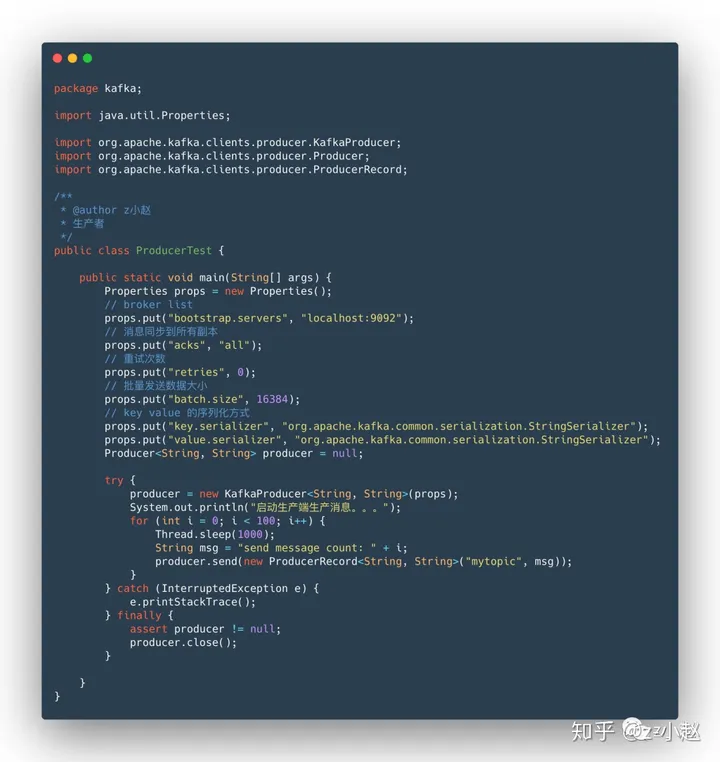

| 153 | +### **4.3 生产者端代码** |

| 154 | + |

| 155 | +<figure data-size="normal"> |

| 156 | + |

| 157 | + |

| 158 | + |

| 159 | + |

| 160 | +</figure> |

| 161 | + |

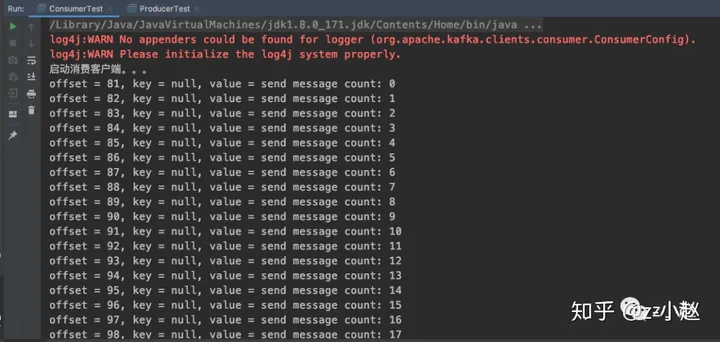

| 162 | +### **4.4 消费者端效果图** |

| 163 | + |

| 164 | +<figure data-size="normal"> |

| 165 | + |

| 166 | + |

| 167 | + |

| 168 | + |

| 169 | +</figure> |

| 170 | + |

| 171 | +### **5.总结** |

| 172 | + |

| 173 | +本文介绍了 kafka 单机版安装及简单命令使用,然后使用 Java 实现了生产者和消费者的简单功能,虽然内容可能比较简单,但还是**强烈建议大家手动去实践一下**,从而对 kafka 的架构有一个更深入的理解。 |

0 commit comments