2024年生成AIの進歩まとめ

こんにちは!逆瀬川 ( https://x.com/gyakuse ) です!

生成AI Advent Calendar 2024の記事を書くの忘れていたので、現時点での生成等AIの進歩をまとめてみました!今日はAIがいまなにできんの?ってこと聞かれたときにこれできるよ!って教えるためのメモとして活用してください!また、生成AIプロダクト Advent Calendar 2024というのもソロでやっています。このカレンダーではLLMの基礎理論からModelのFine-Tuning、プロダクト開発等をまとめています。ぜひこちらも見てください!

未来を感じる技術の進歩

インタラクティブな動画生成では、Genie2 (WASDと方向キーで操作可能な世界モデル)が非常に革新的な進歩を遂げています (振り返っても一貫性を保つ長期性が本当にすごい)。

物理シミュレーションではGenesisが登場しました。

創薬分野ではノーベル賞も受賞したタンパク質構造予測システムであるAlphaFoldの新しいバージョン: AlphaFold3が登場しました。従来のMSA+Evoformerモジュールからの構造予測ではなく、Pairformerから拡散モデルを使った構造予測をするようになっています

ロボティクス分野では自然言語での指示・対話・柔軟なアクションの設計・実行ができるロボットが増えています。まだ発展途中ですが、OpenAIも投資する1xでは家庭向けロボットNeoを開発しています。

普段の仕事に直結しそうな技術の進歩

1. 仕事の効率向上

1.1 マルチモーダルモデルの一般化

2024年はマルチモーダルモデルが一般化し、かつより賢くなり、返答速度が非常に速くなったことが大きな変化として最初に挙げられます。これによって、画像や音声をもとに質問応答を気軽に行うことができるようになりました。

主なモデル:

- ChatGPT: 4o

- Gemini: gemini-1.5-pro

- Claude: Claude-3.5-Sonnet

どんなことができるようになったか:

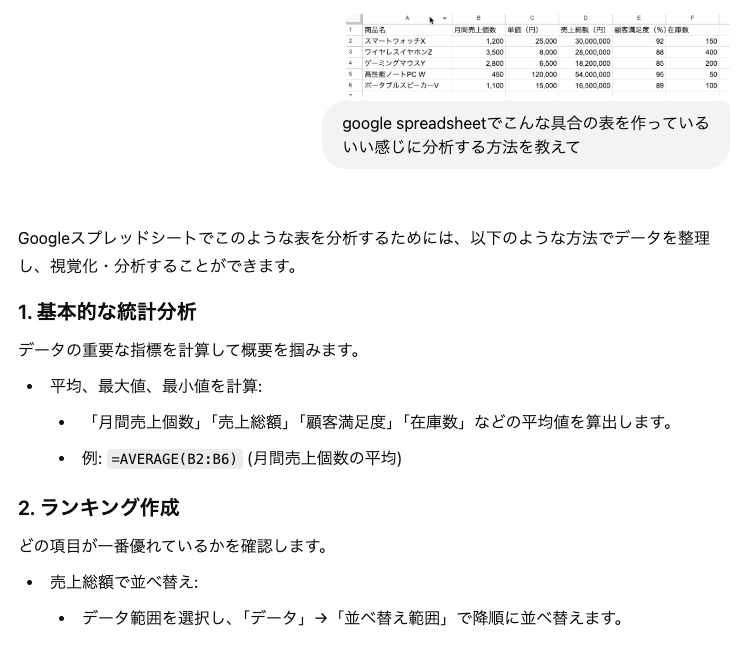

- Excelでわからないことがあったら、スクショして聞けば済むようになった

- PDFをぶんなげて質問応答が気軽にできるようになった

使用例:

1.2 熟慮するモデルの登場

ChatGPTのo1をはじめとする熟慮をするモデルが登場したことによって、いままで短絡的な解答により誤りが発生していたケースを防ぐことができ、またいままでなら複数の会話の応答でやっと到達していた深い結論にゼロショットで到達できるようになりました。

o1は推論時間が長いため (30秒〜1分程度)、使い分けとしては、基礎モデルで解答困難な場合はo1に投げると良いでしょう。

主なモデル:

- ChatGPT: o1, o1 Pro

- Gemini: Gemini 2.0 Flash Thinking Experimental

どんなことができるようになったか:

- 複雑な問題に対してのより深い検討

使用例:

小説のアイデア比較:

- 4o: https://chatgpt.com/share/676733af-7bd0-800d-9aa3-9e2e10da7c05

- o1: https://chatgpt.com/share/676733a4-3b24-800d-b2c2-f61303bb22c3

2. プログラミングの効率化

2.1 開発効率化アプリの浸透

CursorやGitHub Copilotを用いると、非常に効率的にプログラミングを行うことができます。現状、プロジェクトの規模が非常に大きくなるとCursorのようなものは恩恵が小さくなりますが、そのうちいい感じになるはず!とりあえずの人はGitHub Copilotがおすすめです (無料で神です)。

主なツール:

2.2 プログラミング能力の高いモデルの登場

o1 の登場によって、プログラミング能力も向上しました。体感としてはミスの少ない実装ができるようになったと感じます。思考をするべき部分がより抽象的な部分になっていき、その抽象的な部分 (アイデア等) も担保してくれるようにいずれはなるでしょう。

主なモデル:

- ChatGPT: o1, o1 Pro

使用例:

3. 調査の効率化

検索とLLM(あるいはマルチモーダルモデルともいう)を組み合わせると調査タスクが効率化し、従来リサーチ業務として行っていた活動について部分的または全体を置き換えることが可能となります。この分野はまだまだ発展途中ですが、特にNotebookLMは実務でも使えるレベルに達してきました。

主なツール:

使用例:

DeepResearchを使うとこちらのようなレポートがすぐ作成できます: レポート例

詳細はAppendix参照のこと

2025年以降はどのような革新がありうるか

来年すでに予定されている主要なもののひとつにGoogleのProject Astraのメガネ型デバイスがあります。

主に期待される製品としては以下のようなものがあるでしょう:

- AIベースのデバイス・AIアシスタント (スマートフォン、メガネ型デバイス)

- 汎用 / 特定領域向けのエージェント (みんなだいすきだけど, ちゃんと社会にフィットするものはめちゃくちゃ難しい. UIUXはもちろん、全部自動化できない場合は、ワークフローのデザインも大事)

また、o3の登場により、人間程度、あるいは超知能が実現され、大きな社会変革が期待されますが、以下の課題が残っています。

- 長いコンテキスト (テキスト形状だけでなく、動画等含めて) の理解、あるいはRAG的な手法の改善

- 推論コストの低減

- ロボティクスとの連動

開発者にとっての進歩

2024年はエンジニアにとっても進歩のあった年でした。個人的にはgemma-2-2b-jpn-itの恩恵をめちゃくちゃ感じていますが、それ以外にもいくつかインパクトのあるAPI・ライブラリ・モデルが発表されています。

1.公開されたAPI群

公開されたAPIとしては主に以下のようなものがインパクトの大きいものとしてありました。

主なモデル:

- OpenAI

- gpt-4o: マルチモーダルAPI

- o1: 熟慮推論API

- Realtime API: 音声対話用API

- Google

- gemini-1.5-flash: 軽量のマルチモーダルAPI

- gemini-1.5-flash-8b: 最軽量のマルチモーダルAPI

- gemini-1.5-pro: マルチモーダルAPI

- gemini-2.0-flash-experimental: 推論能力が向上した最新のマルチモーダルAPI

- gemini-2.0-flash-exp: 命名が分かりづらいですが、マルチモーダルライブ用のAPIです

- gemini-2.0-flash-thinking-exp: 熟慮推論API

- Anthropic

- Claude 3.5 Sonnet: マルチモーダルAPI

何ができるようになったか:

- 書き起こしが非常に安価に

- gemini-1.5-flashを使うと書き起こしが非常に安価にできるようになりました。コンテキストに用語集を入れることによって、書き起こしのミスを減らすこともできます。なお、timestampを出力させることもできますが、ハルシネーションが起きやすいので(誤ったtimestampをつけがち)、WER低減の恩恵を受けつつtimestampベースの出力を得たい場合は別途Whisper等で書き起こしをしたあとにlevenshtein距離等で突合する必要があります。

- OCRが容易に

- これもgemini-1.5-flash等を使い、structured outputをさせれば、容易に構造的にデータを取り出すことができます (正確にはOCRというよりも画像文書理解タスクですが)

- また、古典的なOCRと組み合わせることでより精度を上げることも可能です: 確信度を出してくれるOCRを作ってみる!

- 音声対話・映像対話が可能に

- Realtime APIを使うと音声対話システムが容易に構築できます。

- また、gemini-2.0-flash-expを使うと映像対話(画面共有・カメラ共有、なおこちら側のみであるため、AI側の映像は別途作らなければならない)ができます

- ただし、APIコストが高く、リクエストできる回数も小さいため、古典的なASR+LLM+TTSが良い場面も多いです

- 参考: 自分のPCオンリーでキャラクターと音声対話がしたい!ローカルで動くspeech-to-speechサーバーを作る方法

2.公開されたライブラリ群

ライブラリは大量にあるため、以下は個人的によく使うものを挙げていきます。

- LLMの推論高速化

-

vLLM

- 言語モデルの高速推論+推論サーバーライブラリです

- 2023年に公開されたものですが、最近は皆これを使うようになってきました。

- 基本的なアイデアとしてはKV Cachingの効率化とバッチ処理の高速化が中心となっています。

- ほかにはTensorRT-LLMなどが有名です。

-

vLLM

- LLMのfine-tuning

-

LLaMA Factory

- とりあえずこれを使えば容易です。他にはtrl, nemoフレームワーク, LLamaTuner, LLMBoxなどがあります (自分はよくtrlを使います)

-

LLaMA Factory

3.公開されたモデル群

以下では注目しているモデル群をみていきます。個人的な興味に基づいているため、偏りがあります。また、基本的に事前学習済みモデルが提供されているものとなります。

- 生成モデル

- テキスト

- 音声

- 3D (3Dモデル, シーン)

- https://github.com/yanghb22-fdu/Hi3D-Official

- https://github.com/facebookresearch/vfusion3d

- https://github.com/pkunliu/Isotropic3D

- https://github.com/thu-ml/CRM

- https://github.com/VAST-AI-Research/TripoSR

- https://github.com/heheyas/V3D

- https://huggingface.co/stabilityai/sv3d

- https://github.com/3DTopia/3DTopia-XL

- https://github.com/3DTopia/LGM

- https://github.com/SOTAMak1r/GVGEN

- https://github.com/NIRVANALAN/GaussianAnything

- https://github.com/wenqsun/DimensionX

- 動画

- https://huggingface.co/THUDM/CogVideoX-5b

- https://github.com/AILab-CVC/VideoCrafter

-

https://github.com/ali-vilab/VGen

- InstructVideo

- DreamVideo

- TF-T2V

- VideoLCM

- https://github.com/Vchitect/Vlogger

- https://github.com/HumanAIGC/AnimateAnyone (2024ではないが)

- LLM

- MLM

- speech-to-speech

- Audio

- ASR

- whisper-large-v3-turbo

- ASR

- Vision

- 深度推定

- 物体検出

- 画像復元

- 動画理解

- 時系列予測

- サーベイ

- https://huggingface.co/thuml/timer-base-84m

-

https://huggingface.co/amazon/chronos-bolt-base

- Chronos-Boltモデルは、Chronosモデルよりも5%精度向上、最大250倍高速化、20倍メモリ効率化を実現した時系列予測モデル

- https://huggingface.co/amazon/chronos-t5-large

- https://huggingface.co/google/timesfm-1.0-200m

- https://huggingface.co/ibm-granite/granite-timeseries-ttm-r2

- https://github.com/kwuking/TimeMixer

- MoE

- データセット

- 推奨記事

- Mamba

主な会社の発表

OpenAI

npakaさんのまとめを参考に時系列で見ていきましょう。

- 5/13 GPT-4o: マルチモーダルかつGPT-4より高速なモデル

- 9/12 o1-preview: 熟慮をすることで推論能力が格段に向上したモデル

- 9/25 Advanced Voice: 滑らかな音声対話をすることができる高度な音声モード、Realtime APIとしても提供され、誰でも高度な音声対話型のチャットボットが作れるように

- 12/5 ChatGPT Pro: 月200ドルでo1を無制限に、またo1 Proを使うことができるより高額な課金体系

- 12/9 Sora: 動画生成サービス。最大20秒まで (1080pの場合10秒まで) 作ることができる

この中では個人的にはo1-previewおよびo1 Proが非常にインパクトの強いものとしてありました。

こちらもnpakaさんのまとめを参考に時系列で見ていきましょう。

- 2/16 Gemini 1.5: GPT-4oのような非常に優秀なモデル

- 2/21 Gemmaシリーズ:

- 5/8 AlphaFold 3

- 5/14 Project Astra: スマートフォンとAIグラスに対応したAIアシスタント (開発中)

- 6/27 Gemma 1.5 Proの最大コンテキスト長が200万トークンに拡張

- 12/4 Genie2

- 12/11 Deep Research

- 12/13 NotebookLM Plus: Notebook LMの

- 12/14 Agentspace

- 12/16 Veo2, Imagen3

- 12/17 Gemini 2.0 Experimental Advanced

その他

- 10/23 Computer Use

Appendix

Deep Research

Gemini 1.5 Proを用いて自動的にレポートを作成してくれる機能。

PerprexityやSearchGPTのような浅い探索ではなく、調査計画を元に非常に多くの記事を収集し、一つのレポートとしてまとめてくれます (Perprexityは計画部分はちゃんとしているが、収集規模が小さく、浅い探索になりがち)。

処理の流れ:

(1) 計画立案

(2) 検索

(3) レポート出力

出力されたものはGoogle Docファイルとして保存可能: サンプル

課題

- ヒットした記事の内容 (特に上位にヒットしたもの) に引っ張られやすすぎる

- 一見、80点程度ありそうに見えるが、実務上はあまり使えない (実務の性質にもよるが、個人的にはレポート依頼プロンプトを調整したり、探索範囲を絞るような依頼でもかなり厳しい場合が多い → 特定のドメイン以下の特定分野に絞る等)

- 日本語だからそうというわけでもない (元は英語のみ対応だったので、英語中心で使ってみていた)

- キュレーション戦略をプロンプトでしっかり定義してあげると良いかも (つまり、調査依頼者が対象領域に対して十分理解しているとうまく働く

ただ、これはそもそも工夫次第でなんとかなるので、改善は早いとみています。個人的に特定領域用のDeep Searchみたいなものを作ったことがあるが、それはうまく動きました。結局多言語かつ汎用的に作るのは難しいという話でもあります。

NotebookLM (Plus)

Deep Researchが直接調査を行ってくれるものだとしたら、NotebookLMは調査をサポートしてくれるサービスといえます。任意のソース (URL, PDF, .txt, .mp3等の各種ファイル, Googleスライド, Google ドキュメント等) をもとにチャットや学習ガイド生成等を行ってくれます。まだ英語のみだが、ポッドキャスト生成も行ってくれます。主に学習や研究の補助といった意図が強い。類似サービスとしては、ChatGPTのやClaudeのProjectが挙げられます。

また、大量のソース (Plusでは最大300) を登録できるため、簡易RAGチャットシステムとしても使える。企業向けのチャットはほとんどこれで賄える気がします。

Discussion