技術負債を返した話(Pre-built GPU Binary対応)

最もプリミティブなPG-Stromの処理は、ユーザが入力したSQLを元にCUDA CのGPUプログラムを自動生成し、これを実行時コンパイル。ここで生成されたGPUバイナリを用いて、ストレージから読み出したデータをGPUで並列処理するという一連の流れである。

後にJOIN/GROUP BYの対応や、データ型の追加、SSD-to-GPU Direct SQLなど様々な機能を付加したものの、このコード生成と実行時ビルドの仕組みは2012年に最初のプロトタイプを公開した時から大きく変わってはいない。

コードの自動生成を担当するのはcodegen.cで、この人が吐いたCUDA Cプログラムをcuda_program.cがNVRTC (NVIDIA Run-Time Compiler) を使ってコンパイルし、GPUバイナリを生成する。

ただ、当初の『全件スキャンWHERE句・固定長データ型のみ』というシンプルなコード生成が、やがてJOIN/GROUP BYや、numeric型やtext型の対応など、より複雑な処理をGPUで実行するようになるにつれて、自動生成部分だけでなく、静的に書いておいた部分と組み合わせてGPUプログラムを生成するようになる。

これは当然で、例えばGPUでHash-Joinを実行する場合でも、クエリを処理するたびに変わる可能性があるのは、二つのテーブルを結合するJoin-Keyの結合条件を評価する部分だけで、Hash-Joinの基本的なアルゴリズムは同じだからである。

これらの静的なCUDA Cコードは、ヘッダファイル(*.h)として記述され、cuda_program.cでコードをコンパイルする時にインクルードする事で、動的生成したコードと組み合わせて使用していた。

ただし…。

PG-Stromの機能が増え、静的なCUDA Cコードの割合が増えるにつれ実行時コンパイルの時間は徐々に増えていく事になる。

intやtextといった基本的なデータ型の比較といった、シンプルなコードであれば気になる程ではないが、例えば、(コーナーケースではあるが)複合型(Composite Type)のデータをGPU側で生成する場合などは、対応する全てのデータ型が関わってくるため、ビルドに要する時間がSQLの実行時間よりも遥かに長くなるという本末転倒な状況が起こる。

その場合、一度ビルドしたGPUバイナリは共有メモリ上にキャッシュされるため、初回と2回目以降のSQL実行時間が大幅に異なるという事になってしまう。

そこで、ほぼ一週間を丸々要してGPUコードの実行時コンパイルに係る部分のリファクタリングを行った。

要は、静的なCUDA Cコードは予めコンパイルして、実行時にはバイナリをリンクすれば済む話なので、ある程度以上に複雑な構造を持つ関数は cuda_gpujoin.cuやcuda_numeric.cuという形で切り出し、PG-Strom自体のビルド時に、NVCCを用いてGPUバイナリファイルを生成するようにした。

これらは動的に生成されたコードと実行時リンクされ、最終的にはこれまでと同じ処理を行うようになる。

静的な部分は Fatbin 形式という形でインストールされる。この形式は、GPUの各世代(Pascal, Volta, Turing)向けに最適化されたバイナリを内部にアーカイブし、ターゲットGPUに最も適したバイナリをリンク時に使用してくれる。

なので、インストールされたPG-Strom関連ファイルを見てみると、目新しいファイルが並んでいる…という事になる。(*.gfatbin ファイルはデバッグオプションを有効にしてビルドしたバージョン。pg_strom.debug_jit_compile_options=onの時にはこちらが利用される)

[kaigai@magro ~]$ ls /usr/pgsql-11/share/pg_strom arrow_defs.h cuda_gpupreagg.fatbin cuda_gpusort.h cuda_numeric.gfatbin cuda_textlib.gfatbin cuda_basetype.h cuda_gpupreagg.gfatbin cuda_jsonlib.fatbin cuda_numeric.h cuda_textlib.h cuda_common.fatbin cuda_gpupreagg.h cuda_jsonlib.gfatbin cuda_plcuda.h cuda_timelib.fatbin cuda_common.gfatbin cuda_gpuscan.fatbin cuda_jsonlib.h cuda_primitive.fatbin cuda_timelib.gfatbin cuda_common.h cuda_gpuscan.gfatbin cuda_misclib.fatbin cuda_primitive.gfatbin cuda_timelib.h cuda_gpujoin.fatbin cuda_gpuscan.h cuda_misclib.gfatbin cuda_primitive.h cuda_utils.h cuda_gpujoin.gfatbin cuda_gpusort.fatbin cuda_misclib.h cuda_rangetype.h pg_strom--2.2.sql cuda_gpujoin.h cuda_gpusort.gfatbin cuda_numeric.fatbin cuda_textlib.fatbin

ベンチマーク

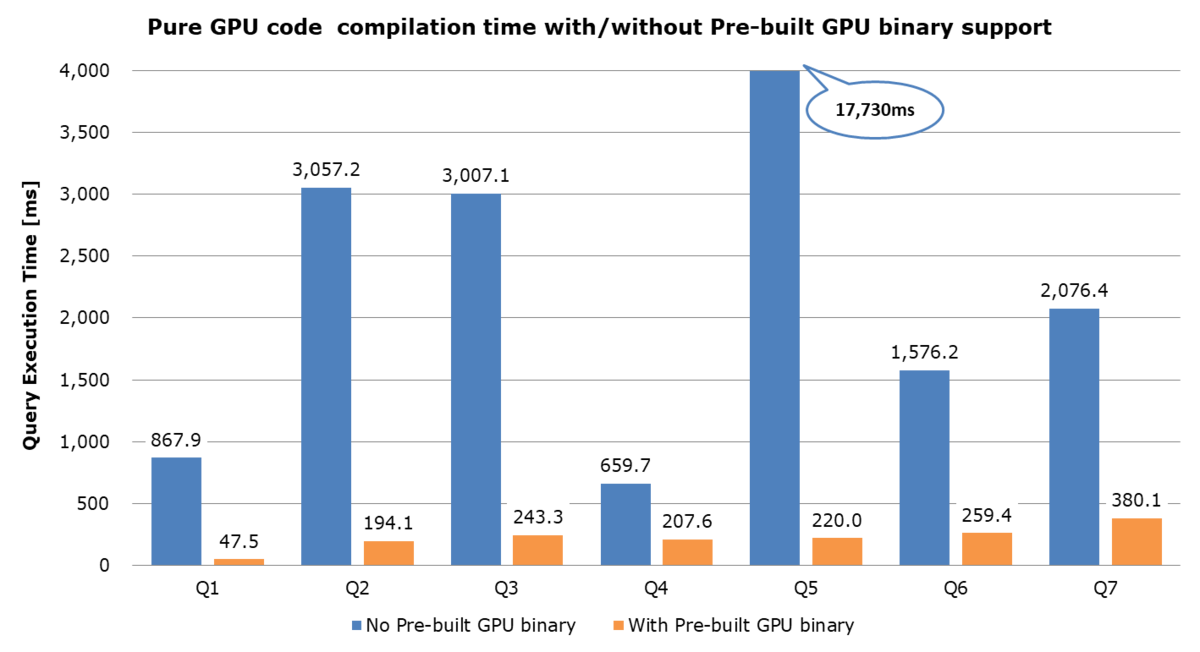

GPUコードのビルドに要する時間を計測するため、何種類かのテスト用クエリを作成し、その実行時間を計測してみた。

とりあえずクエリは以下の7種類で計測してみた。

-- Q1 ... シンプルなGpuScan + Int型の演算 SELECT id, aid+bid FROM t0 WHERE aid < 100 AND bid < 100; -- Q2 ... Numeric型を利用するGpuScan SELECT id, a+b, a-c FROM t_numeric1 WHERE a < 50.0 AND b < 50.0; -- Q3 ... Timestamp型とEXTRACT()文を使用するGpuScan SELECT id, a, b FROM t_timestamp1 WHERE EXTRACT(day FROM a) = 19 and EXTRACT(month FROM b) = 6; -- Q4 ... Arrow_Fdw外部テーブルからシンプルなデータ(Int, Timestamp)の読み出し SELECT id,ymd FROM t_arrow WHERE id % 100 = 23; -- Q5 ... Arrow_Fdw外部テーブルから複合型(Composite)の読み出し SELECT id,v FROM t_arrow WHERE id % 100 = 23; -- Q6 ... GpuJoinを含むクエリ SELECT id, aid, atext FROM t0 NATURAL JOIN t1 WHERE bid < 50 AND cid < 50; -- Q7 ... GpuPreAgg + GpuJoinを含むクエリ SELECT cat, count(*), sum(ax) FROM t0 NATURAL JOIN t1 GROUP BY cat;

ディスクからの読み出しの影響を排除するため、関連する全てのテーブルをpg_prewarmでオンメモリ状態にした上で、上記の7つのクエリをそれぞれ2回ずつ実行した。

以下の表/グラフはその結果であるが、静的なCUDA Cコードを事前にビルドしておく事で、初回の実行時間が大幅に改善しているのが分かる。もちろん、最終的なGPUバイナリはほぼ同じ形になるので、ビルド済みGPUバイナリのキャッシュを参照できる2回目以降では処理時間の大きな差はない。(単位は全てms)

ちなみにQ5はめちゃめちゃ時間がかかっている。これは、Arrow形式(列データ)から複合型のデータをGPU上で再構成し、CPUへは行データとして返すという、非常にコード量の多い処理を行っているためである。

| 旧方式(1回目) | 旧方式(2回目) | 新方式(1回目) | 新方式(2回目) | |

|---|---|---|---|---|

| Q1 | 1,199.6 | 331.7 | 369.0 | 321.5 |

| Q2 | 3,279.2 | 222.0 | 421.6 | 227.5 |

| Q3 | 3,213.5 | 206.5 | 462.6 | 219.2 |

| Q4 | 793.7 | 134.0 | 355.1 | 147.4 |

| Q5 | 17,872.2 | 141.4 | 364.7 | 144.8 |

| Q6 | 1,928.5 | 352.3 | 605.3 | 345.9 |

| Q7 | 2,435.6 | 359.2 | 729.1 | 349.1 |

分かりやすいように、Pre-built GPU Binary機能の有無別に(2回目の実行時間)-(1回目の実行時間)を計算してみる。2回目は共有メモリ上のキャッシュを参照するだけなので、これが正味のビルド時間という事になるが、これまでは『一呼吸おいて』という感じだった部分がコンマ何秒程度にまで短くなった事が分かる。

背景

実はこの機能、別の要件を考えた時にどうしても急いで作らざるを得ない事情があった。

これまでユーザさんからの新機能の要求を優先して実装していたために、テストケースの作成やテスト自動化が後回しになってきた経緯があったのだが、エンタープライズ向けにはこれらソフトウェア品質改善/品質保証のためのプロセスは必要不可欠であり、今年の後半は少し腰を落ち着けてテストの充実を図ろうと考えている。

ただ、大量のテストを流すとなると、相応のバリエーションのSQLを実行する事となり、その度にGPUコードの自動生成と実行時コンパイルが走るのでは、テストケースの実行に非常に長い時間を要してしまう事になる。これではPG-Stromのテストをしているのか、コンパイラを動かしているのか分からない!