次世代CPU「Lunar Lake」でIntelが目指す“AI PC”とは? 驚くべき進化点と見える弱点、その克服法(4/4 ページ)

NPUコアはCore Ultraプロセッサ(シリーズ1)比で3倍に増量

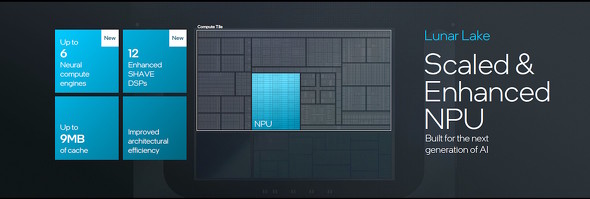

Lunar Lakeには、Core Ultraプロセッサ(シリーズ1)で搭載されていた「NPU 3」の進化版となる「NPU 4」が搭載されている。

NPU 4は、NPUコア「Neural Compute Engine(NCE)」の基数をNPU 3の3倍に当たる6基に増量している。NCE1基当たりの演算能力は、FP16(16bit浮動小数点演算)で1クロック当たり1024回、INT8(8bit整数演算)で1クロック当たり2048回で変更はない。

また、NPU 4には推論プロセッサの他、128bitのSIMD-VLIWプロセッサである「SHAVE(Streaming Hybrid Architecture Vector Engine) DSP」も引き続き搭載されている。SHAVE DSPはNCE1基当たり2つ、合計で12基が搭載されている。

余談だが、SHAVE DSPはIntelが2016年に買収したMovidiusが設計したDSPである。

Intelが公称するNPU 4の公称スペックは、INT8演算時で48TOPSだという。先代のMeteor LakeのNPU3におけるINTの理論性能値を計算すると、以下の通りとなる。

2048OPS×2 NCE×2 OPS(積和算)×1.4GHz=11.47TOPS

このことを踏まえて、48TOPSから逆算すると、こんな計算式ができる。

48TOPS=2048OPS×6 NCE×2 OPS(積和算)×X GHz

上の計算式における「X」は、NPU 4の動作クロックだ。この式をXについて求めると、「X≒1.953GHz」という値が出てくる。概算ではあるが、Lunar LakeのNPU 4は1.953GHzくらいで動作しているものと思われる。CPUコアのクロックも、同じだろう。

Lunar Lake唯一の弱点は「メモリ」 それを克服する新機能とは?

Lunar Lakeは、15Wクラスの低消費電力CPUであり、リアルモバイル系の薄型ノートPC向けのCPUとなる。ゆえに“単体で”完成されたPCシステムを実現しなければならない(いわゆる「SoC(System On a Chip)」の類となる)。

セキュリティ面への多角的なハードウェア対応はもちろんのこと、接続性や拡張性に関しても、最新世代の技術への対応がなされている。

無線LANはWi-Fi 7(IEEE 802.11be)に対応し、Bluetoothも最新の5.4を利用できる。外部機器との接続にはPCI Express 5.0バスとPCI Express 4.0バスをそれぞれ4レーンずつ用意し、IntelプラットフォームらしくThunerbolt 4ポートも統合している。

なお、Lunar LakeのThunderbolt 4ポートはPCI Express 4.0/5.0バスとのレーンとは“別枠”で用意されている。

セキュリティ回りの機能と、各種接続/拡張ポートはPlatform Controlerタイル内で提供される。従来のモバイル向けメインストリームCPUとは異なり、無線LANやBluetoothも“チップ内”に統合されている

セキュリティ回りの機能と、各種接続/拡張ポートはPlatform Controlerタイル内で提供される。従来のモバイル向けメインストリームCPUとは異なり、無線LANやBluetoothも“チップ内”に統合されているここまで見ると「Lunar Lakeは完成度が高い」と思ってしまうのだが、すごく細かい所まで見ると、気になる点がないわけではない。

ハイパースレッディング機構の廃止は一定の合理性があるので理解できる。「AI PC」を訴求する関係で、GPUでXMXが復活し、NPUも一気に3倍の性能に引き上げているのも、開発コンセプトと合致する。

問題は、メモリ回りだ。

容量:「AI PC」に最大32GBは心もとない

第一に最大メモリ容量が32GB止まりという点が気にかかる。チップ上にメモリを置く設計もあってか、DIMMスロットなどを活用しての増設は想定されていないし、当然ながらチップ上に実装されているメモリを換装することもできない。

AI PCというコンセプトが「小規模な推論モデルを実践(実行)する」程度なら32GBのメモリでも十分だとは思う。しかしIntelは「本機単体で大規模な生成AIをローカル動作させられる」と強調していた。そうなると「32GBでは心もとなくない?」とどうしても思ってしまう。

ちなみに、Core Ultraプロセッサ(シリーズ1)では、Lunar Lakeと同じ15Wクラスの製品(Uプロセッサ)でも最大96GBのメモリをサポートしている。

メモリバス:狭いがゆえに速度が出ない

第二にメモリバスの狭さとメモリー帯域の狭さも気になる。この部分も、残念ながらCore Ultraプロセッサ(シリーズ1)のUプロセッサに対して見劣りする。

Core Ultraプロセッサ(シリーズ1)のUプロセッサでは、LPDDR5X-7500規格のメモリモジュールを使うと毎秒120GBのアクセススピードを確保できた。しかし、これがLunar Lakeの場合、メモリモジュールこそ、より高速なアクセスに対応できるLPDDR5X-8500規格なものの、メモリバス幅が半分の64bitしかないため、アクセス速度は毎秒68GBにとどまる。

対策:ラストレベルキャッシュを搭載

Intelも、この問題に対して無策なわけではない。メモリアクセス性能を補うべく、「Memory Side Cache」と呼ばれる、8MBのラストレベルキャッシュメモリを搭載した――ということである。

AI系の学習/推論処理、各種グラフィックスレンダリングやレイトレーシング処理において、このキャッシュメモリがどの程度パフォーマンスを向上する効果を持つのか、興味が集まる所だ。

メモリバスの狭さと帯域の小ささを補うべく、ComputeタイルのCPUブロックやGPUブロックからも切り離された所に「Memory Side Cache」が設置された。ある種、Lunar Lakeの生命線的ともいうべき機能ブロックといえる

メモリバスの狭さと帯域の小ささを補うべく、ComputeタイルのCPUブロックやGPUブロックからも切り離された所に「Memory Side Cache」が設置された。ある種、Lunar Lakeの生命線的ともいうべき機能ブロックといえる関連記事

Intelのモバイル向け次世代CPU「Lunar Lake」は2024年第3四半期に登場 ライバルを超えるAI処理パフォーマンスを実現

Intelのモバイル向け次世代CPU「Lunar Lake」は2024年第3四半期に登場 ライバルを超えるAI処理パフォーマンスを実現

Intelが、モバイル向け次世代CPU「Lunar Lake」の概要を発表した。2024年第3四半期に登場する予定で、ライバルCPU/SoCよりも高速なAIパフォーマンスを発揮できることが特徴だ。 「AI PC」がベールを脱ぐ! 次世代のモバイル向け「Core Ultraプロセッサ」正式発表 搭載ノートPCは順次発売

「AI PC」がベールを脱ぐ! 次世代のモバイル向け「Core Ultraプロセッサ」正式発表 搭載ノートPCは順次発売

Intelが発表を予告していた「Core Ultraプロセッサ」が、ついに正式発表された。全てのモデルにAIプロセッサ(NPU)を搭載しており、NPUを利用できるアプリのパフォーマンスが大きく向上することが特徴だ。 さよなら「i」 こんにちは「Ultra」――Intel Coreプロセッサが15年ぶりにリブランディング Meteor Lakeから適用

さよなら「i」 こんにちは「Ultra」――Intel Coreプロセッサが15年ぶりにリブランディング Meteor Lakeから適用

2023年後半に登場する新型CPU「Meteor Lake(開発コード名)」に合わせて、IntelがCoreプロセッサのリブランディングを実施する。モデル名に含まれる「i」を省く他、「第○世代」という表記を廃止することでブランドそのもののシンプル化を進める一方で、最先端モデルには新たに「Core Ultraプロセッサ」というブランドを導入するという。 Intelが次世代CPU「Meteor Lake」の概要をチラ見せ 全モデルに「AIエンジン」を搭載

Intelが次世代CPU「Meteor Lake」の概要をチラ見せ 全モデルに「AIエンジン」を搭載

Intelが「Meteor Lake(メテオレイク)」というコード名で開発を進めているCPUの概要情報を公開した。同社初の7nmプロセスCPUは、全モデルにCPUコアとは別体の「AIエンジン」を搭載するという。 2025年までに「1.8nm相当」に――Intelが半導体生産のロードマップを説明

2025年までに「1.8nm相当」に――Intelが半導体生産のロードマップを説明

Intelが半導体生産のロードマップを説明するイベントを開催した。2022年には7nmプロセスの製品が、2024年には新技術を取り入れた製品が登場する見通しだ。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

アクセストップ10

- デスクトップPCこそ「Thunderbolt 4」が便利 実は導入ハードル低く、ケーブル類がスッキリ (2025年01月06日)

- AMDが新GPUアーキテクチャ「RDNA 4」をチラ見せ GPU名は「Radeon RX 9000シリーズ」に (2025年01月07日)

- モバイルに「L3キャッシュ爆盛り」とApple/Intel対抗の「GPU強化モデル」登場――AMDが新型「Ryzen」を一挙発表 (2025年01月07日)

- Intelが「Core Ultraプロセッサ(シリーズ2)」のラインアップを一気に拡大 ノートPC向けを中心にデスクトップPC向けや組み込み用も (2025年01月06日)

- NVIDIAが新型GPU「GeForce RTX 50シリーズ」を発表 新アーキテクチャ「Blackwell」でパフォーマンスを約2倍向上 モバイル向けも (2025年01月07日)

- HP、2025年に投入するPCの新製品を披露 Intel版「EliteBook Ultra」など次世代AI PCを本格展開 (2025年01月07日)

- ASUSがAMD B850/B840チップセット採用マザーボード10製品を発表 (2025年01月07日)

- ASUSがIntel B860チップセット搭載マザーボードを多数発表 3万円台からスタートで発売は1月14日から (2025年01月07日)

- Dell、AI PCの製品ブランドを刷新 「Pro、Pro Max」など3つのカテゴリーとティアでグレードを分かりやすく (2025年01月07日)

- ASRockがAMD B850搭載マザーを発表、国内でも投入 Intel B860/H810搭載製品や裏配線対応モデルも (2025年01月07日)